El uso de bots en redes sociales para comentar publicaciones ocurre principalmente en páginas de comercio digital poco confiables. Su objetivo es convencer al usuario de que un producto o servicio es legítimo, aunque en realidad no lo sea, mediante reseñas o comentarios falsos que generan confianza y llevan al usuario a realizar acciones como comprar o compartir.

Aunque este tipo de automatización es común en ciertos contextos comerciales, su aparición en otros ámbitos puede generar preocupaciones distintas.

También te puede interesar: Cierra temporada de temperaturas extremas con 6.1% de casos más que en 2024

Cuando este tipo de automatización aparece en publicaciones de dependencias gubernamentales, la percepción cambia. Podría interpretarse como un intento de simular apoyo o neutralizar críticas, distorsionando la conversación ciudadana.

¿Qué es un bot?

En entrevista con Ruptura360, Emilio Belmonte Bierbaum, estudiante de Ingeniería Electrónica en Nova Southeastern University con especialización en Inteligencia Artificial, definió un bot como “una cuenta generada mediante un algoritmo, generalmente falsa, que interactúa de manera automática en redes sociales”.

Entre las señales más claras de un bot destacan: un alto volumen de comentarios con contenido similar, perfiles con pocos seguidores y muchas cuentas seguidas, y actividad rápida que no corresponde con interacciones humanas.

Por otra parte, existen los chatbots, herramientas legales que algunos gobiernos municipales utilizan para mejorar la atención ciudadana. A diferencia de los bots, los chatbots no buscan influir en la opinión pública; su propósito es práctico.

Un ejemplo es Monterrey, cuyo chatbot, disponible en WhatsApp bajo el nombre de “Regina”, ofrece menús para reportar baches, vehículos abandonados o solicitar apoyos sociales. Estos chatbots simulan conversaciones con usuarios para responder preguntas o guiar procesos, dejando claro que la interacción no es con una persona real, sino con un sistema automatizado de servicio público.

Por consiguiente, la automatización en redes no es negativa en sí misma; su impacto depende del contexto y la intención detrás de su uso.

Actividad automatizada: Bots en redes sociales afectan interacción ciudadana

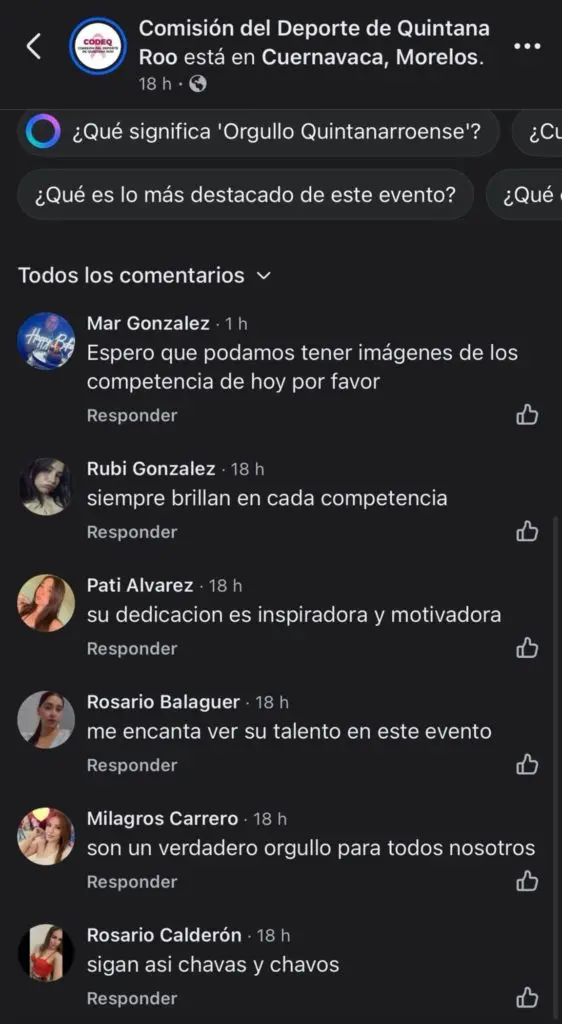

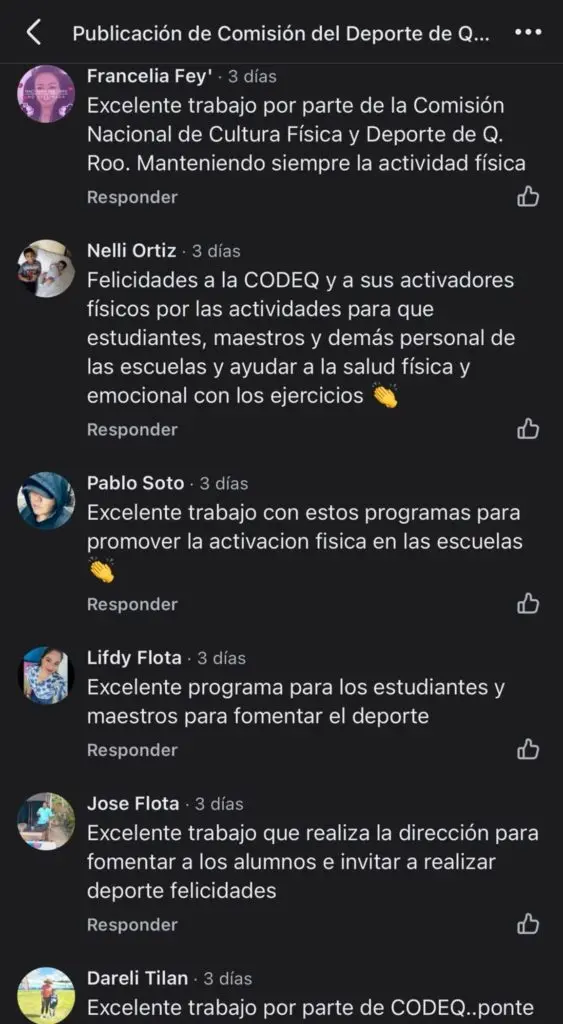

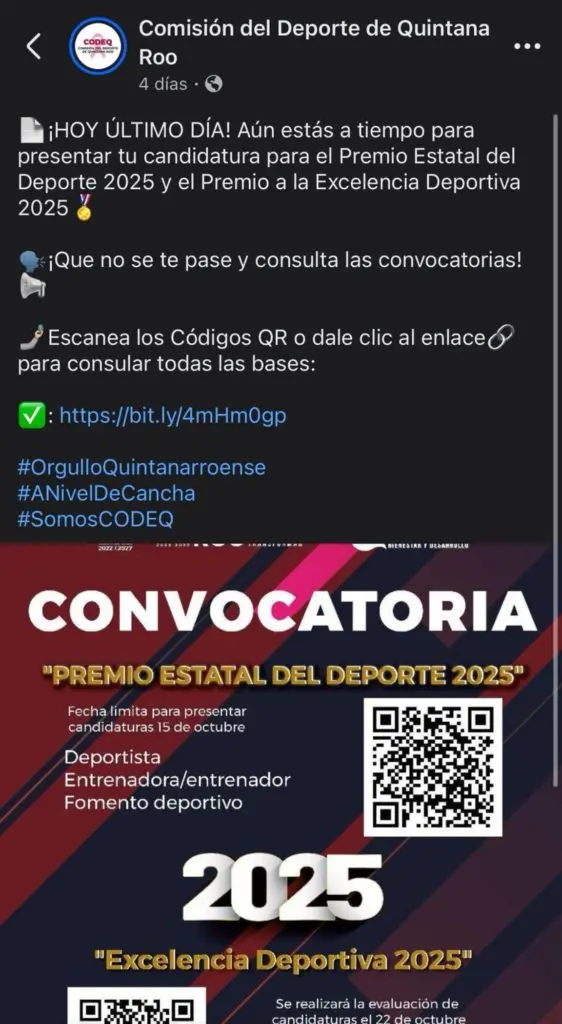

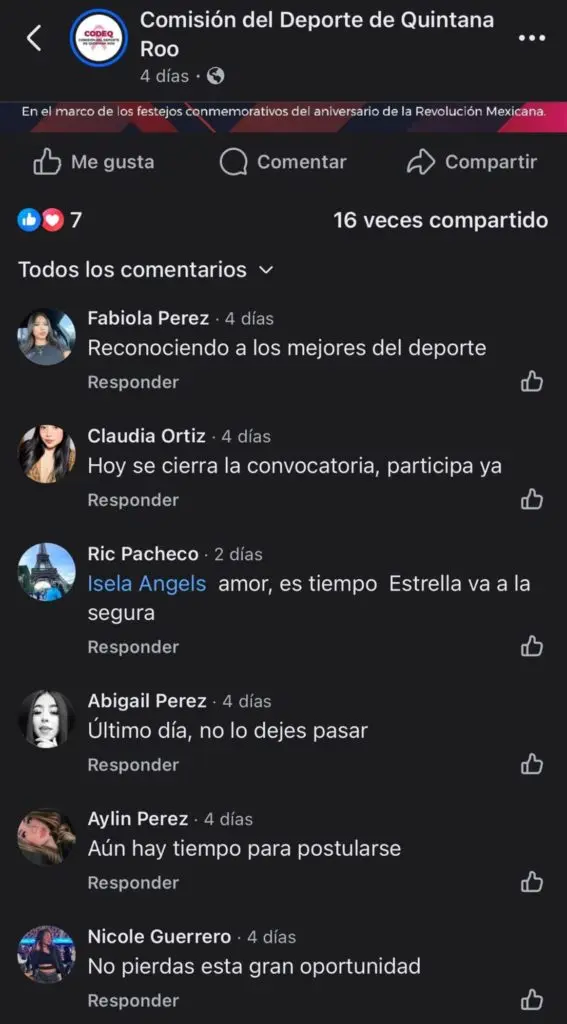

En las publicaciones más recientes de la Comisión del Deporte de Quintana Roo (CODEQ), encabezada por Jacobo Arzate Hop, se detectan comentarios con características similares a las descritas por Belmonte Bierbaum: vocabulario repetitivo, tono uniformemente positivo y perfiles con indicadores de automatización.

Mantener una red de bots en redes sociales, explica Belmonte Bierbaum, no requiere grandes recursos: basta con una computadora y conocimientos básicos de programación, o incluso adquirir servicios en línea de bajo costo que generan comentarios automáticos.

Automatizar mensajes positivos bajo cuentas inexistentes constituye, según Berta García-Orosa (2021) en su artículo “Desinformación, redes sociales, bots y astroturfing: la cuarta ola de la democracia digital”, un mecanismo de manipulación del discurso político, creando la impresión de apoyo ciudadano que no existe de manera orgánica.

En ese sentido, si un gobierno —directa o indirectamente— recurre a la automatización para simular apoyo o contrarrestar críticas, estaría alterando la conversación pública. En este terreno todo se vuelve difuso: no siempre está claro quién mueve los hilos. Podría tratarse de una estrategia institucional o de un grupo afín.

Esa ambigüedad, donde lo auténtico y lo fabricado se mezclan, deja una pregunta inevitable: ¿Qué tan auténtica es la voz ciudadana en redes?